Technik und Literaturübersetzen – willkommen im 21. Jahrhundert

Übersetzen? Das machen doch jetzt Maschinen. Mag sein, aber für Bücher gilt das nicht. Oder etwa doch?

Redaktioneller Hinweis: Am Ende dieses Essays befindet sich ein Glossar mit Erklärungen zu den wichtigsten Fachbegriffen.

Die Tücken der lernenden Maschine

Im Januar 2019 besuchte ich mit befreundeten Kollegen einen Vortrag am FTSK Germersheim. Gleich zum Auftakt empfahl Daniel Zielinski, Geschäftsführer von Loctimize und wissenschaftlicher Mitarbeiter des FTSK im Bereich Sprachwissenschaft und Translationstechnologie, den Studierenden, ihr Übersetzerstudium an den Nagel zu hängen: Die selbstlernenden NMT-Engines seien zu gut. Das einzige Problem mit der Künstlichen Intelligenz (KI): Man wisse morgens nicht, was sie abends übersetzen würde.

Diese Aussage irritierte mich so sehr, dass ich eine eigene Fallstudie durchführte, deren Ergebnisse ich im November bei der BDÜ-Konferenz „Übersetzen und Dolmetschen 4.0 – Neue Wege im digitalen Zeitalter“ vorstellte.

Anhand eines konkreten kreativen Textes ging ich verschiedenen Fragen nach und bezog freiberuflich tätige Kolleg*innen ein, die ihre Aufgabe (Übersetzen oder Posteditieren) zu ihrem regulären Honorar durchführten. Sie gaben mir ehrlich Auskunft, wie viel Zeit sie tatsächlich investiert hatten, und ich wertete nach einem bestimmten Schema aus, was beim Schlusslektorat noch auffiel.

Was ich dabei feststellte, war:

– Die Mehrzahl der ohne großen Aufwand zugänglichen Übersetzungsmaschinen (in meinem Test: DeepL, Bing, GoogleTranslate und Yandex) lieferte brauchbare, teilweise aber unvollständige und inkonsistente Übersetzungen.

– Die Ergebnisse waren nicht jeden Monat identisch. Nach einem Update seitens der Anbieter konnte die maschinelle Übersetzung desselben Textes besser oder auch schlechter ausfallen – das entsprach der Aussage von Zielinski, die mich zu diesem Experiment veranlasst hatte.

– Eine zuverlässige Übersetzung ist zu erwarten, wenn die übersetzende Person das Thema durchschaut. Das gilt sowohl für die Eigenübersetzung „von Hand“, als auch für die Korrektur einer maschinellen Vorübersetzung.

– Unter hohem Zeitdruck zu übersetzen, zu editieren oder zu korrigieren, ist fehlerträchtig. (Dafür gab es ein separates Szenario mit Zeitlimit.)

– Das Schlusslektorat ist bei einer Humanübersetzung einfacher als bei einer maschinellen Übersetzung, weil Menschen andere Fehler machen als die Maschine. Besonders zu beachten ist dabei, dass ein maschinell übersetzter Satz wunderschön geschmeidig aussehen, aber dennoch Fehler enthalten kann, zum Beispiel Auslassungen oder eine Sinnentstellung. Humanübersetzer hingegen stellen Fragen (sich selbst und dem Auftraggeber) und tappen daher nicht so schnell in diese Fallen.

– Der Versuch, eine maschinelle Vorübersetzung auf das Niveau einer menschlich erstellten zu bringen, kann bei kreativen Texten mehr Zeit kosten als die Erstellung einer eigenen Neuübersetzung. Die scheinbare Ersparnis beim schnellen Ergebnis rächt sich in der Nachbearbeitung – am Ende spart man nichts.

– Umgekehrt gilt: Post-Editieren ist Übungssache und kann eine schnelle, korrekte Übersetzung liefern, wenn es primär auf Inhalte ankommt, nicht auf sprachliche Finessen.

[Ergänzung: Wenn man mit einem CAT-Tool arbeitet (einem Programm für Computer Assisted Translation), lassen sich spezielle NMT-Engines und eigene Terminologie einbinden. So bekommt man automatische Vorschläge von der gewählten Übersetzungsmaschine. Das führt zu besseren Vorübersetzungen mit weniger Nachbearbeitungsaufwand, erscheint mir aber urheberrechtlich fragwürdig (siehe unten).]

Mit diesen Ergebnissen im Hinterkopf nahm ich im November 2019 am Übersetzertag des Deutschen Übersetzerfonds im LCB „Geist in Maschinen. Übersetzung in Zeiten der künstlichen Intelligenz“ teil, wo sich Fachleute für NMT mit der Literaturübersetzerszene und Verlagen austauschten. Trotz der beeindruckenden Leistungen aktueller KI lautete damals die einhellige Meinung der Teilnehmenden: Die Maschine kann brauchbare Bausteine liefern – fast wie eine einfallsreiche, belesene Praktikantin. Ein guter, sinnstiftender Text braucht jedoch ein menschliches Gehirn – die Praktikantin stutzt und fragt nach, die Maschine nicht.

Im Gedächtnis blieben mir als Nicht-Informatikerin die Erklärungen des Wissenschaftlers und Unternehmers Samuel Läubli, warum NMT-Ergebnisse aus menschlicher Sicht so rätselhaft unzuverlässig sind: die „Künstliche Intelligenz“ denkt nicht, sondern sie errechnet aus vorhandenen Texten und bestimmten Vorgaben Wahrscheinlichkeiten. Sie sucht nicht nach Sinn und versteht den Inhalt nicht.

Zementierte Klischees

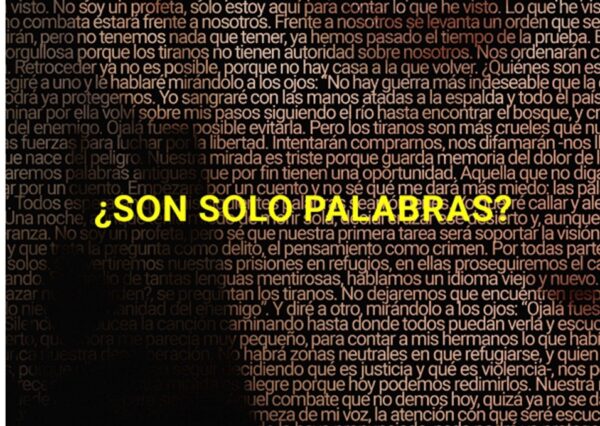

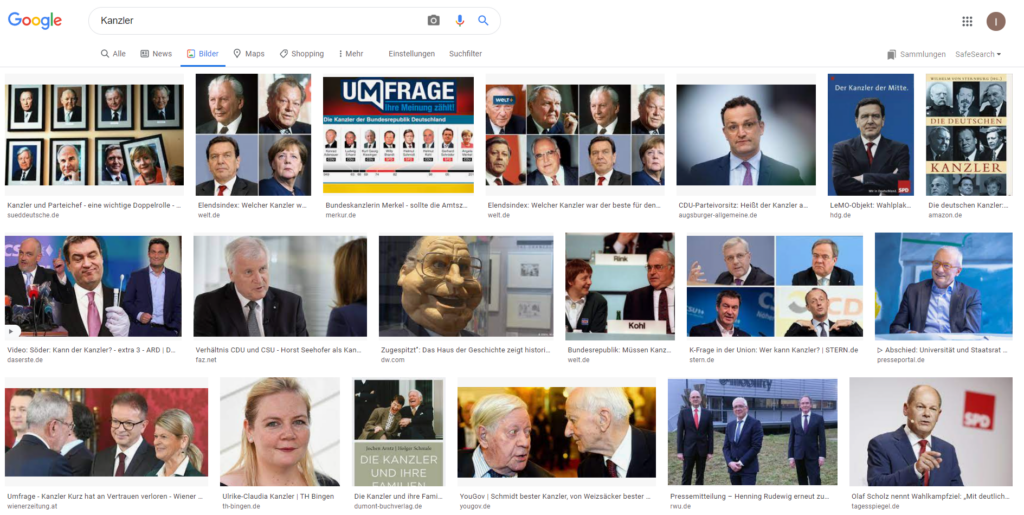

Im Frühjahr 2021 bat mich das Goethe-Institut Finnland im Zuge seiner Webinar-Reihe „Artificially correct“ um einen Impulsvortrag zur Frage, ob Übersetzungsmaschinen die Gender-Wahrnehmung beeinflussen. Diesem Thema näherte ich mich über die Bildersuche, die ich gern nutze, um zu prüfen, ob ein von mir gewählter Begriff wirklich passt. Ein Bild lügt nicht, oder? Theoretisch stimmt das, aber über „tags“ ist das Bild mit Begriffen verknüpft, die im Hintergrund automatisch übersetzt werden und an denen sich Suchmaschinen orientieren. Dabei schieben sich je nach Sprache unterschiedliche Bilder nach vorn. Für den englischen Suchbegriff „German chancellor“ erschienen 2021 (vor der letzten Bundestagswahl) viele Bilder von Angela Merkel.

Gab ich dann auf Deutsch „Kanzler“ ein, so sah ich diese Zusammenstellung:

Google-Bildersuche zum wort „Kanzler“. Quelle: Screenshot der Autorin, 22.3.2021.

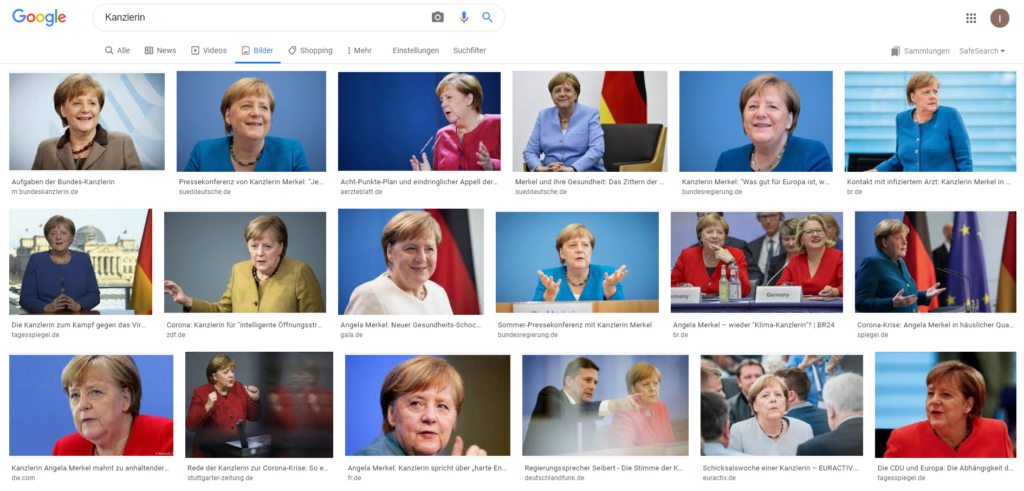

Es waren Bilder von Kanzlern, mitunter mit Angela Merkel in einer langen Reihe Männer, dazu eine Frau mit dem Namen Kanzler. Erst als ich explizit nach „Kanzlerin“ suchte, kamen Bilder der damals aktuellen Regierungschefin:

Google-Bildersuche zum Wort „Kanzlerin“. Quelle: Screenshot der Autorin, 22.3.2021.

Die Maschine, die deutsche Suffixe korrekt deuten konnte und prompt auf eine Flut von Wort-Bild-Kombinationen zurückgriff, in denen Männer der Standard waren, zeigte in aller Deutlichkeit, wie die sprachkonservative Aussage „Beim generischen Maskulinum sind Frauen mitgemeint“ Frauen bis heute selbst auf höchster politischer Ebene unsichtbar macht. Die „neutrale“ KI hält für relevant, was häufig ist, und sortiert ihre Ergebnisse entsprechend. Das halte ich für riskant, weil es veraltete Rollenmodelle reproduziert und das Ringen von Minderheiten um mehr Sichtbarkeit konterkariert.

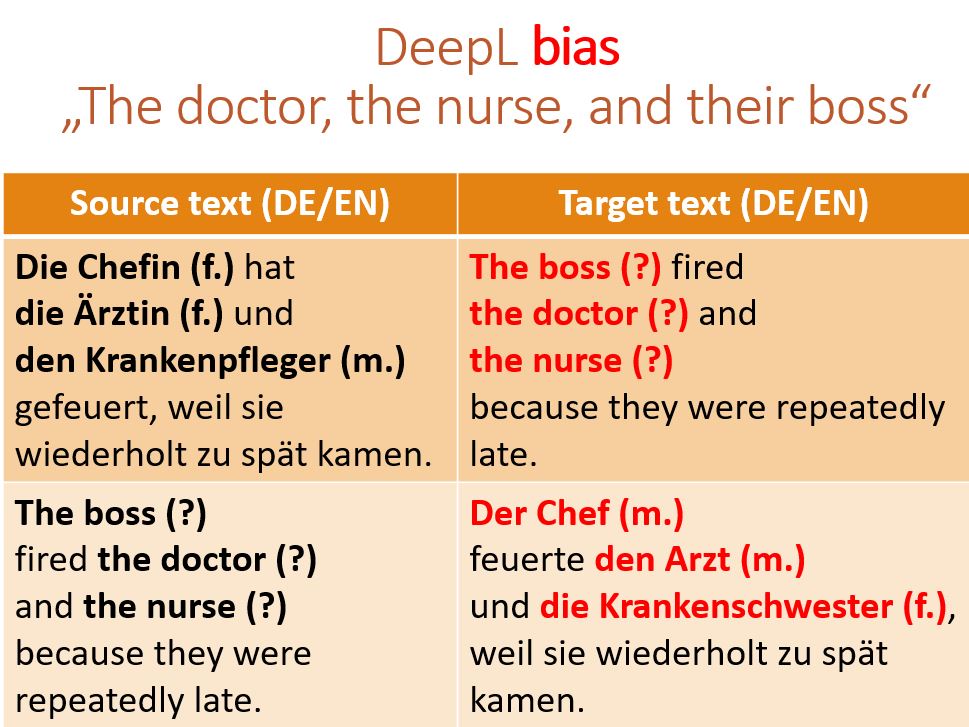

Bei einzelnen Sätzen liefert auch das beliebte DeepL veraltete Klischees. Ein Miniversuch mit Sätzen aus der Medizin, zwischen Englisch und Deutsch hin und her übersetzt, erbrachte unter anderem dieses Ergebnis:

Quelle: Screenshot der Autorin, 22.03.21.

Mit mehr Kontext könnte das Ergebnis anders ausfallen, aber insgesamt ist die Tendenz deutlich. Wir müssen somit jedes neuromaschinelle Übersetzungsergebnis mit Argusaugen betrachten.

Hinzu kommt, dass veraltete Begrifflichkeiten favorisiert werden, weil diese in ihren Ausgangstexten offenbar insgesamt häufiger vorkamen. Bei unkritischem Einsatz von NMT in der Literatur könnte es also sein, dass veraltete Begrifflichkeiten und Rollenverteilungen aufpoppen, die ich erkennen und bereinigen muss.

Lieber Flow als Fehlersuche

Beim Posteditieren muss das Gehirn anders arbeiten, denn NMT-Fehler sind anders als menschliche Fehler. Die Maschine will keine Geschichte erzählen, Protagonisten, Entwicklungen und stilistische Feinheiten sind ihr herzlich gleichgültig – eine Person, die in Kapitel 3 duzt, kann dieselbe Gesprächspartnerin in Kapitel 5 wieder siezen, wenn die Maschine glaubt, dass in dieser Situation normalerweise gesiezt wird.

Das unablässige Prüfen von Vorschlägen („Ja“ oder „Nein“) ist kognitiv anstrengend. Also lässt man Vorschläge, die man selbst so nicht geschrieben hätte, eher mal durchrutschen, wenn sie nicht ausdrücklich falsch sind. Die Maschine stupst uns durch die Vorübersetzung in eine bestimmte Richtung, es klingt spontan akzeptabel, und dieser Stups (das Priming) erschwert es uns, eine Szene oder einen Dialog freier zu formulieren. Wir bleiben näher am Ausgangstext, und damit ist die Übersetzung zwar korrekt, aber nicht so gut, als wäre der Text durch ein neugieriges, gut geschultes Gehirn gewandert.

Das erzeugt eine Unzufriedenheit, die sogar wissenschaftlich festgehalten wurde. In einer Studie von 2018 störten sich Literaturübersetzer*innen beim Postediting von Maschinenübersetzung an der Konditionierung auf die wortgetreue Übersetzung: „They complained that the MT systems ‚conditioned‘ them to produce a literal translation, and found the limitation of sentential segmentation awkward.”[01]Moorkens, Joss & Toral, Antonio & Castilho, Sheila & Way, Andy (2018). Translators’ perceptions of literary post-editing using … Fußnote lesen‘

Was auf der Strecke bleibt, ist der Aspekt des Flow, den gerade Literaturübersetzende kennen: Wir wollen in Inhalt und Setting eintauchen, unser Vorwissen aus früheren Aufträgen und Recherchen einfließen lassen und ein optimales Ergebnis erzielen. Wir sehen Szenen innerlich vor uns, hören die Dialoge, das Heulen des Windes und das Krachen der Wellen. Wir spüren die Enttäuschung, die Getriebenheit oder das Glück unserer Protagonist*innen und wollen vorhandene Vielschichtigkeit übertragen. Nicht selten entdecken wir dabei sogar kleine Ungereimtheiten im Ausgangstext, die wir in Abstimmung mit Autoren bzw. Verlag bereinigen.

Das konzentrierte Ringen um das passendste Wort, die treffendste Redewendung, den optimalen Anschluss, das Stilmittel, das die Intention von Text und Autor*in widerspiegelt (im Fachbuch gern noch passende Vergleichsdaten oder Anmerkungen für die deutschsprachige Leserschaft) – das alles ist ungemein befriedigend. Und dieses Gefühl bleibt aus, wenn ich an einem vorübersetzten Text herumknete, Störfaktoren wie kleine, harte Steinchen herauspicke und versuche, aus der Wortmasse ein stimmiges Gesamtergebnis zu formen.

NMT in der Literatur – was sagt die Forschung?

Der Einsatz von NMT in der Literaturübersetzung wird aus vielerlei Blickwinkeln erforscht. Einen guten Überblick liefern Konferenzen wie die CALT2021 (Computer-Assisted Literary Translation Conference) der University of Swansea, Wales.

Als Fantasy-Übersetzerin war ich auf den Vortrag von Damien Hansen (University of Liège) gespannt. Eine vollständige Version seines Vortrags „The figure of the literary translator amid new technologies” ist als PDF einsehbar (Preprint). Sein Fazit deckte sich mit meinen eigenen Erfahrungen: CAT-Tools sind nützlich, Maschinenübersetzungen bisher unbefriedigend.

Immer wieder fallen mir Ana Guerberof Arenas und Antonio Toral auf, die ebenfalls auf der CALT21 vertreten waren. Nachdem dieses Team 2019 vielversprechende Ergebnisse präsentierte, kam ihre Veröffentlichung von 2021 zu dem Ergebnis, dass literarische Übersetzungen, die ohne maschinelle Unterstützung von Profis erstellt wurden, im Vergleich am kreativsten ausfielen und die beste Leseerfahrung boten. Und in einem Artikel von 2022 heißt es ohne Umschweife, dass die Ergebnisse von NMT mit Postediting häufig nicht zur Veröffentlichung taugen:

„A neural MT system trained on literary data does not currently have the necessary capabilities for a creative translation; it renders literal solutions to translation problems. More importantly, using MT to post-edit raw output constrains the creativity of translators, resulting in a poorer translation often not fit for publication, according to experts.” CREAMT: Creativity and narrative engagement of literary texts translated by translators and NMT (Arenas & Toral, EAMT 2022)

Das passt zu der Erkenntnis, dass stilometrisch bei einer konventionell angefertigten Übersetzung nicht nur die Autorenstimmen erkennbar bleiben (alles andere wäre ein Armutszeugnis), sondern auch individuelle Vorlieben der Übersetzenden. Das konnten El-Fiqi, Petraki und Abass 2019 nachweisen: „These results demonstrate that classic tools based on lexical features can be used for identifying translator stylometry if they get augmented with appropriate non-parametric scaling.”[02]El-Figi H. & Petraki E. & Abbass H.A. (2019). Network motifs for translator stylometry identification. PLoS ONE 14(2). Den Text gibt es hier. Das wiederum ist urheberrechtlich relevant.

Wie ist das mit dem Urheberrecht?

Beim Urheberrecht wirft der Einsatz der Maschine Fragen auf, die selbst für Laien auf der Hand liegen dürften. Fachanwälte kennen mit Sicherheit noch weitere und auch die entsprechenden Paragraphen.

Das Urheberrecht der Autor*innen

In eine Buchveröffentlichung — ob Sachbuch oder Belletristik, ob für Kinder oder für Erwachsene — ist in aller Regel sehr viel Sorgfalt eingeflossen. Jemand hat darüber nachgedacht, hat je nach Genre an Gliederung und Verständlichkeit, Stilebene, Lebendigkeit und Rhythmus gefeilt und das Werk so lange umgeschrieben, bis es endlich stimmig war. Danach hat ein fachliches und/oder stilistisches Lektorat das Ergebnis noch einmal kritisch geprüft.

Nach meinem Wissensstand habe ich als Übersetzerin schlichtweg nicht das Recht, dieses Werk ohne Wissen und Zustimmung der Personen, die das Urheberrecht innehaben, und der Verlage, die die Nutzungsrechte erworben haben, in eine Übersetzungsmaschine einzufüttern. Auch wenn diese Maschinen den Text nicht als Ganzes reproduzieren würden, bekommen sie damit gegebenenfalls kostenloses Futter für ihre Analysen.

Falls ich mir auf einem geschützten Server aus von mir erstellten Übersetzungen eine eigene autorenspezifische MT-Engine bauen würde, sähe das anders aus; da ginge es aus meiner Sicht eher um Qualität und Aufwand. Aber dummerweise weiß ich normalerweise nicht, was in den Verträgen von Originalverlag und Autor oder von meinem Verlag mit dem Originalverlag steht. Darum würde ich ohne schriftliches Einverständnis des Auftraggebers keine maschinelle Übersetzung nutzen.

Das Urheberrecht der Maschine

Eine Übersetzung aus einer öffentlich zugänglichen Maschine geht normalerweise mit einem „Stempel“ einher: etwa „Übersetzt von DeepL“. Das ist für Eingeweihte ein Warnzeichen: „Diese Übersetzung bitte mit Vorsicht betrachten, sie ist berechnet, nicht durchdacht.“ Im Postediting bedeutet das je nach Textsorte und Auftraggeber: „Hier noch einmal im Kontext genau hingucken – könnte stimmen, muss aber nicht.“

Laut European Language Resource Coordination steht der Maschine derzeit kein eigenständiges Urheberrecht zu. Aber werden wir eines Tages unsere Tantiemen mit den großen Maschinenanbietern teilen müssen, deren Siegeszug durch die Verwertung unserer Vorarbeit überhaupt erst möglich wurde?

Das Urheberrecht der übersetzenden Zunft

In der Forschung werden E-Books in Original und Übersetzung als Quelltexte ausgewertet (sicher auch durch Datenkraken wie Google oder Amazon, die ihre Übersetzungsmaschinen gewinnbringend vermarkten und deshalb größtes Interesse an Textressourcen haben). Ein Verweis darauf findet sich in der bereits erwähnten Veröffentlichung von Moorkens, Toral, Castilho und Way (2018) „Translators‘ perceptions of literary post-editing using statistical and neural machine translation”:

„(…) These e-books are an ideal resource for training literary-adapted MT systems, both using monolingual data (novels in a digital format) and bilingual or parallel data (digital novels and their translations). Literary translation will test the ability of NMT systems to efficiently produce translations that, followed by PE, move beyond the limited quality expectations of perishable texts.“

Detaillierte Erläuterungen finden sich in dem Artikel Post-editing Effort of a Novel with Statistical and Neural Machine Translation von Toral, Wieling und Way (2018). Dort werden auch diverse literarische Übersetzungen und Sprachrichtungen erwähnt, bei denen mit Maschinenübersetzung experimentiert wurde.

Und was ist mit meinem Urheberrecht?

Als Literaturübersetzerin fände ich es sehr fragwürdig, wenn ein Verlag nach den ersten drei oder vier Büchern beim nächsten Band dieser Autorin meine Übersetzungen und die Originale in eine Maschine einspeisen würde und das neue Ergebnis nur noch per Postediting nachbearbeiten ließe. Aus meiner Sicht wäre das eine unzulässige Verwertung meiner geistigen Leistung. Übersetzen heißt nicht „in einer anderen Sprache abtippen“; es bedeutet Denkarbeit, bis der Text auf Deutsch eine vergleichbare Wirkung erzielt wie im Original. Zumal ich je nach Zielgruppe auch Sprechbarkeit und Satzrhythmus für eine eventuelle Hörbuchversion berücksichtige.

Der Erfolg eines Werks steht und fällt mit übersetzerischen Entscheidungen. Interessant zu lesen für Fantasy-Liebhaber sind hierzu das Interview mit Gerald Jung von 2011 zur Neuübersetzung von Terry Pratchetts Scheibenwelt-Romanen und ein Blogartikel von Eva Bergschneider von 2019 zur Neuübersetzung von Tolkiens Herr der Ringe durch Wolfgang Krege in Abgrenzung zur alten Übersetzung durch Margaret Carroux. Sehr spannend ist auch die Diskussion über die Neuübersetzungen von George Orwells 1984, das nach deutschem Recht inzwischen gemeinfrei ist. In ihrem Artikel Welche Übersetzung soll ich lesen?“ hat Julia Rosche 2021 für die Plattform TraLaLit die verschiedenen Versionen verglichen.

Ist es legitim, wenn die Internetdatenkraken diese geistige Leistung als Maschinenfutter verwerten, sobald die Versionen als E-Book vorliegen?

NMT im Literaturübersetzen – der Praxistest

Während ich noch an diesem Artikel tüftelte, stieß ich im Juli 2022 auf den Blogbeitrag von Miriam Neidhardt Kann man ein Buch mit DeepL übersetzen? Als erfahrene Übersetzerin nahm sie im Frühjahr 2022 einen interessanten Auftrag an: „Übersetze den dritten Krimi einer Autorin ins Deutsche und lektoriere die ersten beiden Übersetzungen.“ Dabei stellte sich heraus, dass die erste Übersetzung offenbar unter Nutzung von DeepL entstanden war, die zweite von einer erfahrenen Übersetzerin. Das war eine perfekte Ausgangsbasis, um den Zeitaufwand für normales Lektorat und die eigene Übersetzung mit dem Aufwand für Post-Editing zu vergleichen. Der Beitrag ist unbedingt lesenswert, zumal die Autorin darin systematisch typische NMT-Schwächen bei kreativen Texten auflistet. Und alles deckt sich mit meinen bisherigen Beobachtungen und dem Stand der Forschung.

Stand Mitte 2022 kann ich zusammenfassend sagen: Der Einsatz neuronaler maschineller Übersetzung bietet für die literarische Übersetzung keinen Mehrwert.

Ein Teil der Gründe wurde bereits genannt:

– Fehler treten an unerwarteter Stelle inmitten glatter Sätze auf.

– Wenn ich mein Thema beherrsche und der Stil mir liegt, übersetze ich zügig in eine brauchbare Version. Dabei kann ich dem Lektorat bei wichtigen Begriffen oder Stilfragen mitteilen, für welche sprachliche Lösung ich mich aus welchem Grund entschieden habe.

– Umgekehrt müsste ich ständig analysieren, ob das, was die Maschine entscheidet, passt oder nicht. Und ich kann mich nicht darauf verlassen, dass sie in einem späteren Abschnitt nicht wieder dieselbe Fehlentscheidung produziert, die ich zuvor schon wegkorrigiert habe.

– Posteditieren ist insgesamt mühsamer und erschwert das Lektorat durch mitdenkende Menschen. Die Denkarbeit muss dennoch geleistet werden, aber die Maschinenversion schiebt sich zwischen mein Gehirn und das Ursprungswerk.

Andere Gründe sind subtiler:

– Autoren entwickeln sich. Sie lernen dazu, reagieren auf Publikum und Zeitgeist und experimentieren mit Sprache, Form und Inhalten. Das Erstlingswerk einer Autorin kann sich stilistisch stark von ihrem Spätwerk unterscheiden. Diese Entwicklung sollte sich in der Übersetzung spiegeln.

– Figuren und Handlung entwickeln sich auch innerhalb eines Werks. Ein Begriff, der im ersten Buch einer Reihe passend erscheint, muss später vielleicht angepasst werden. Das ist am Anfang einer längeren Serie nicht immer ersichtlich, weil die Folgebände noch gar nicht geschrieben sind.

– Sprachgebrauch, Kultur und Rezeption verändern sich. Was in bestimmten Zeiten als normal galt, kann 20 Jahre später Unbehagen oder Befremden erzeugen und 100 Jahre später dazu führen, dass ein Klassiker nur noch als Zeitdokument lesbar ist – die Geschichte mag zeitlos sein, die sprachliche Gestaltung hingegen ist veraltet. Überholte rassistische, sexistische oder anderweitig diskriminierende Begriffe müssen nicht erneut in Umlauf gebracht werden, nur weil sie früher einmal „ganz normal“ waren. Als Mensch kann ich mit marginalisierten Gruppen sprechen und neue Lösungen suchen. Beispiele für Autorinnenmut und die Diskussionen hinter den Kulissen, welche Sprache heute angemessen ist, schildern auch Lucy Gasser und Anna von Rath in ihrem Babelwerk-Essay von Mai 2022.

– Jedes Werk entsteht im Kontext – auch ohne wörtliche Zitate ist es eingebettet in einen Kosmos aus Lese-, Film- und Welterfahrung. Ein Mensch erkennt solche Einbettungen und Zitate und kann Strategien ausloten, sie in die Zielsprache hinüberzuretten. Mal ist dazu ein winziger, eingeflochtener Satzteil erforderlich, mal muss ein Filmzitat klingen wie in der Synchronfassung, mal muss man ergänzend ein Glossar erarbeiten.

Und was mache ich nun mit dem Zeitdruck seitens der Verlage? Das Manuskript ist gekauft, passt zu einem bestimmten Trend und soll möglichst schnell vorliegen. Ich möchte schnell und trotzdem gut (oder besser als bisher) übersetzen, ohne meine Gesundheit samt Work-Life-Balance zu ruinieren. Darum nutze ich sinnvolle Hilfsmittel.

Nützliche Technik fürs Literaturübersetzen

Auf moderne technische Hilfsmittel möchte ich für meine Arbeit nicht mehr verzichten. Das wäre angesichts stagnierender Honorare weder qualitativ noch wirtschaftlich vertretbar.

Manche Übersetzende diktieren mit Profisoftware wie Dragon Naturally Speaking, gern „der Drache“ genannt. Das bietet sich besonders für Romane an, in denen die Dialoge möglichst natürlich klingen sollen. Man erspart sich viel Tipperei, muss aber besonders aufmerksam nachbearbeiten. Ein gern genutzter Trick ist auch, die fertige Übersetzung beim Korrigieren von der Spracherkennung vorlesen zu lassen und parallel zu korrigieren.

Ich persönlich mag klassische CAT-Tools, die den Ausgangstext in einzelne Sätze zerlegen. Der große Vorteil ist, dass man keinen Satz oder Abschnitt mehr auslässt. Was ich später kürzen, gesondert prüfen oder umstellen will, kann ich dabei mit Sonderzeichen oder Kommentaren markieren.

Solche Tools (wie Wordfast, Trados Studio, MemoQ und diverse andere) lassen sich mit dem aktuellen Duden kombinieren. Man kann digitale Wörterbücher einbinden und bekommt beim Schreiben automatisch Vorschläge für Schlüsselwörter des Ausgangssatzes eingeblendet (Autosuggestfunktion). Besonders komfortabel sind auftragsspezifische Termbanken, in denen man Eigennamen, Ortsnamen oder spezifische Begriffe (in meinen Fantasy-Romanen gern Monster, Waffen oder Zaubersprüche) hinterlegen kann. Solche Datenbanken kann man beim Arbeiten miterstellen, und so werden die Vorschläge beim Schreiben immer spezifischer. In der Fantasy liebe ich diese Funktion für komplizierte Namen, im Sachbuch für chemische Substanzen und Krankheiten – nie mehr verschreiben!

Im Gegensatz zum klassischen Umgang mit solchen Tools bleiben die Translation Memories allerdings in der Literatur in der Regel Rohversionen, denn beim eigenen Überarbeiten wie auch beim externen Schlusslektorat und -korrektorat oder auch erst im Satz werden aus diversen Gründen noch Sätze gestrichen oder zusammengezogen, umgestellt, Schlüsselbegriffe nach Absprache noch abgeändert und vieles mehr. Zumindest die Termbank muss danach noch einmal aufmerksam aktualisiert werden, um später keine Begriffe mehr anzubieten, die es nicht in die Endversion geschafft haben. Und selbst ein zu 100 Prozent identischer Satz kann in meinem Memory in mehreren Versionen auftauchen, weil ich ihn an dieser Stelle anders formulieren möchte.

Für Schlusslektorat, Recherche, Charakterverwaltung und eine bessere Übersicht kommen professionelle Autorentools samt Content Management System (CMS) in Betracht, zum Beispiel Papyrus Autor oder Patchwork. Gerade für große Projekte ist es von Vorteil, Rechercheergebnisse, Inhaltsschnipsel, Personen- oder Ortsbeschreibungen auf diese Weise übersichtlich abzulegen und immer wieder darauf zugreifen zu können. Zudem bieten solche Programme auch Optionen wie Autokorrektur und Stilstatistik – eine gute Chance, geschmeidiger zu schreiben, die gewählte Stilebene durchgängig beizubehalten und Lieblingsfüllwörtern auf die Spur zu kommen. Ob sich der Aufwand lohnt, ist individuell abzuwägen.

Man kann je nach CAT-Tool Elemente aus der maschinellen Übersetzung nutzen und automatisch erzeugte Übersetzungsvorschläge bekommen. Das habe ich ausprobiert, fand die Ergebnisse aber so unbefriedigend, dass ich diese Option abgeschaltet habe. Man kann auch kostenpflichtige Übersetzungsmaschinen einbinden – das tue ich aus urheberrechtlichen Gründen nicht, aber auch weil es mich aus dem Flow reißen würde.

In der Fantasy muss ich Bücher analysieren und die deutsche Fassung so gestalten, dass die Leserschaft darauf anspringt. Im Sachbuch brauchen mich „meine“ Autor*innen, damit ihre Überlegungen das deutschsprachige Publikum erreichen, zu Diskussionen anregen oder Menschen konkret helfen. Den Ausgangstext hat keine Maschine geschrieben, sondern ein Mensch für andere Menschen. Ein Buch ist keine knappe Sachinformation — es soll berühren und in den Bann ziehen oder ein Thema begreiflich machen, zum Nachdenken anregen oder gar zum Handeln. Darum verdient jede Buchübersetzung ein aufmerksames menschliches Gehirn.

—

Und wenn Sie nach dieser langen Lektüre noch eine Runde lachen wollen, empfehle ich den FAZ Kommentar, „Lost in Translation“, (29.04.2021) von Jan Wiele, der am Beispiel automatisch übersetzter Buchtitel bei Ebay zur „Markterschließung“ und „Verkaufsbeschleunigung“ beschreibt, wo NMT völlig fehl am Platze ist.

—

Disclaimer: Dieser Artikel erwähnt aufgrund der Thematik zahlreiche kommerzielle Unternehmen. Alle Erwähnungen sind als informative Beispiele einzustufen, nicht als Kaufempfehlung.

—

Glossar

CAT-Tool. CAT ist die englische Abkürzung für Computer Assisted Translation, also computerunterstützte Übersetzung. Programme dafür heißen CAT-Tools und sind technischer Standard beim Übersetzen. Sie gestatten Terminologieverwaltung, die erneute Verwendung vorhandener Textbausteine („Matches“), die Einbindung elektronischer Wörterbücher und die Berücksichtigung vorhandener Referenztexte. Außerdem erleichtern sie die kundenspezifische Auftragsbearbeitung. Moderne CAT-Tools bieten die Möglichkeit, kostenpflichtige Abonnements für maschinelle Übersetzung (MT) und neuronale Maschinenübersetzung (NMT) einzubinden oder direkt auf den Servern der Auftraggeber zu arbeiten.

GPT-3. Ein technologisches Sprachmodell, das auf Deep Learning basiert, damit NMT technisch durchaus ähnlich ist und über die reine Satzvervollständigung hinaus Texte weiterschreiben kann — auch in verschiedenen Sprachen. Es basiert auf ca. 45 TB Textdaten, die über 175 Mrd. Parameter miteinander verknüpft sind.

KI. Künstliche Intelligenz (englisch: AI, für „artificial intelligence“). Aus mathematischen bzw. statistischen Modellen werden Wahrscheinlichkeiten abgeleitet. Moderne KI-Modelle wie GPT-3 beziehen Kontext und gewünschte Stilebene ein.

MT. Englische Abkürzung für „machine translation“. Beim maschinellen Übersetzen (auf Deutsch auch als MÜ abgekürzt) werden Textbeispiele statistisch ausgewertet und zu entsprechenden Übersetzungsvorschlägen genutzt. Die derzeit vorherrschende Technologie in der maschinellen Übersetzung ist die Neuronale Maschinelle Übersetzung (NMT).

MT-Engine. Die eigentliche Übersetzungssoftware, die nach bestimmten Kriterien maschinelle Übersetzungen der Texte erzeugt, die ihr vorlegt werden. In der Regel laufen solche „Maschinen“ auf externen Servern mit hoher Rechenkapazität.

NMT. Englische Abkürzung für „neural machine translation“, also Neuronale Maschinelle Übersetzung (NMÜ). Dahinter steckt die Vorstellung, dass die Künstliche Intelligenz sich mittels Deep Learning (der eigenständigen Auswertung großer Textmengen) ähnlich wie ein menschliches Gehirn selbst organisiert. Sie kann und soll die Regeln des Ausgangsmodells verändern und erweitern, als würde sie selbst Neuronen bilden und über sprachliche Logik eigenständige Schlüsse ziehen.

Postediting (PE). Englischer Begriff (Deutsch: Post-Editieren) für die Überarbeitungsphase, inzwischen gern verkürzt als Synonym für (N)MTPE verwendet, also das Nachbearbeiten von Texten, die durch NMT vorübersetzt wurden. Postediting bei MT/NMT-Übersetzungen erfordert hohe Konzentration, Fachkenntnis und Mitdenken, aber auch eine gewisse Flexibilität bei der Akzeptanz der Maschinenentscheidung. Es findet zumeist innerhalb des CAT-Tools statt, kann aber auch als nachträgliches Lektorat am fertigen Text genutzt werden.

TB. Englische Abkürzung für „Termbase“ bzw. Terminologie-Datenbank. Ein Glossar mit der Möglichkeit, zwei- oder mehrsprachigen Einträgen auch Quellenangaben, Links und Notizen hinzuzufügen. Solche Datenbanken lassen sich beim Literaturübersetzen fachspezifisch bzw. autorenspezifisch aufbauen, in der Fantasy auch weltspezifisch. Sie werden während der Auftragsbearbeitung und in separaten Arbeitsgängen erweitert und aktualisiert. Die Glossareinträge werden beim Arbeiten vom CAT-Tool vorgeschlagen.

TM. Englische Abkürzung für „translation memory“ (Deutsch: Übersetzungsspeicher). Eine für CAT-Tools elementare Datenbank, in der alle Sätze, Teilsätze oder Satzfragmente eines Textes in einem bestimmten Format zweisprachig als „Segment“ abgespeichert sind. Kunden-, fach- und autorenspezifische TMs sind der über viele Jahre erarbeitete Arbeitsschatz von Übersetzer*innen.

| ↑01 | Moorkens, Joss & Toral, Antonio & Castilho, Sheila & Way, Andy (2018). Translators’ perceptions of literary post-editing using statistical and neural machine translation. Translation Spaces 7. S. 240-262. Den Artikel-Volltext gibt es hier. |

|---|---|

| ↑02 | El-Figi H. & Petraki E. & Abbass H.A. (2019). Network motifs for translator stylometry identification. PLoS ONE 14(2). Den Text gibt es hier. |